سال هاست که گوگل با بحران شدید خزش صفحات سایت مواجه است. روزانه تعداد زیادی وبسایت راهاندازی میشوند که گوگل باید آنها را بررسی و دیتا سنتر خود را بروز نگه دارد. یکی از راه حلهای بهینه سازی نرخ خزش رباتهای گوگل، ساخت و مدیریت فایل Robots.txt است.

Robots.txt فایلی است که در هاست شما؛ در دایرکتوری اصلی قرار میگیرد و برای رباتهای مختلف از جمله رباتهای گوگل، تابلوهای ورود ممنوع قرار داده است.

ساخت و بهینه سازی فایل Robots.txt یکی از بخشهای سئو تکنیکال است که در صورت نیاز میتوانید از آن بهره زیادی ببرید.

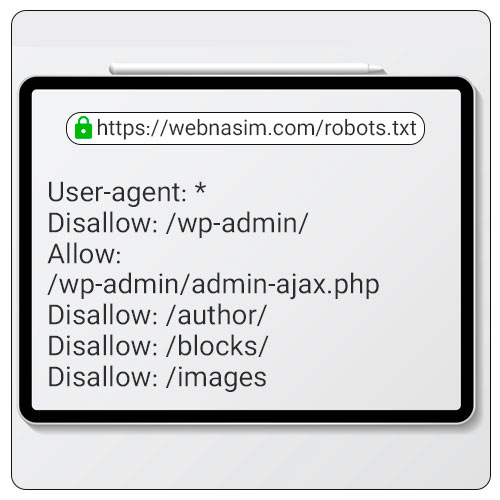

نمونه فایل Robots.txt

فایل Robots با پسوند txt ساخته میشود که در دایرکتوری اصلی قرار میگیرد که نمونه آن در تصویر بالا آمده است. این فایل تنها با نام Robots باید ساخته شود تا کارایی داشته باشد.

پارامترهایی در این فایل قرار دارد که هر کدام معنا و مفهومی خاص را انتقال میدهد:

User-agent: به معنای نوع رباتی است که ملزم به رعایت این قوانین است. برای مثال اگر این قوانین را برای ربات گوگل قرار داده اید لازم است آن را Googlebot قرار دهید اما در صورتی که ربات دیگری مد نظر دارید نام آن را در این بخش بگذارید.

در صورتی که قصد دارید دستورات فایل Robots.txt را برای تمامی رباتها قرار دهید، از * استفاده کنید. دقت داشته باشید در این فایل، هرجایی * قرار گیرد به معنای “همه” میباشد.

اگر ستاره (*) را پس از User-agent قرار دهید به معنای این است که مخاطب شما تمامی رباتهاست.

Disallow: غیر مجاز بودن خزش صفحه برای ربات مورد نظر!

Allow: مجاز بودن خزش صفحه برای ربات مورد نظر!

آموزش ساخت فایل robots.txt در وردپرس

ساخت و مدیریت این فایل کار سختی نیست چه به صورت دستی و چه بوسیله پلاگین در وردپرس!

- برای ساخت فایل Robots.txt در وردپرس تنها لازم است افزونه Robots.txt Editor را از مخزن وردپرس دانلود و نصب کنید.

- پس از فعالسازی افزونه، در بخش تنظیمات ⇐ خواندن، پایین صفحه میتوانید محتویات فایل Robots.txt خود را مشاهده و آن را ویرایش کنید.

- پس از ویرایش فایل میتوانید گزینه ذخیره تعییرات را کلیک کنید تا فایل ویرایش شده ذخیره شود. میتوانید این فایل را با زدن گزینه View robots.txt مشاهده کنید.

کاربرد استفاده از فایل Robots.txt

این فایل با مدیریت بودجه خزش یا Crawl Budget میتواند موجب شود صفحات با ارزش سایت شما سریعتر خزش و ایندکس شود.

ما در فایل Robots، تابلوهای ورود ممنوعی قرار میدهیم تا از ورود رباتها به آن صفحات جلوگیری کنیم. زیرا ممکن است صفحه دارای تگ Noindex باشد اما بهرحال خزش برای آن صورت میگیرد و باعث هدر رفتن بودجه خزش خواهد شد.

نحوه ویرایش فایل Robots.txt

دقت کنید که این فایل تنها برای قرار دادن صفحاتی استفاده میشوند که قصد خزش آنها را توسط ربات ها نداریم که با دستور Disallow نوشته میشوند. در فایل Robots.txt آدرس ها به صورت نسبی قرار خواهند گرفت؛ برای مثال صفحه ورود را که دارای آدرس Https://webnasim.com/login است را به صورت login/ قرار میدهیم.

با قرار دادن این آدرس، صفحات زیر دست آن هم از دسترس رباتها خارج میشوند مگر اینکه با دستور Allow جدا شده باشند. به دستور زیر دقت کنید:

User-agent: googlebot

Disallow: /books

در این دستور، صفحه books و صفحات بعد از آن مانند books/seo-learning از دسترس رباتهای گوگل خارج میشوند. اما ممکن است در زیر دستههای صفحه book آدرسی باشد که قصد خزش و ایندکساش را داریم. این صفحه استثنا را اینگونه مشخص میکنیم:

User-agent: googlebot

Disallow: /books

Allow: /books/technical-seo

در دستور بالا مشخص کردیم که صفحه books و زیر دستههای آن از دسترس رباتهای گوگل خارج شوند اما صفحه books/technical-seo که یکی از زیر دستههای صفحه books است، قابل دسترس توسط رباتهای گوگل خواهد بود.